以布里斯托市A38路旁的喷泉池为起始点,你需要花用不到20分钟时间,就可以骑自行车“冲”出这座英国西南部都市的CBD,进入险些只有成排英式平房、灌木丛和河流的郊野。

没错,即便布里斯托(Bristol)是名副实在的英国西南部中央,但从都市规模来看,但它依然被许多中国留学生起了一个异常清新脱俗的名字——“布村”。( “除了伦敦,其他都是村儿”。)

然而,现在接触芯片产业后,我们才恍然发现,这座古老的英国小城,竟然藏着英国最壮大的半导体产业集群之一。

1972年,硅谷赫赫有名的仙童半导体(英特尔、AMD的首创人们都是从这家公司出来的)为进入欧洲市场做出了一个主要决议——在布里斯托设立一个办事处。自此,便打开了这座英国西部小城面向半导体产业的全球视野。

而6年后,降生于布里斯托,并在80年代占有全球SRAM市场60%份额的微处置器公司Inmos,接受了卡拉汉政府与撒切尔政府高达2亿英镑的投资,才终于缔造出以布里斯托焦点的英国半导体基础设施与生态系统,召集了大批像XMOS 半导体首创人、英国著名盘算机科学家David May这样的半导体超级精英。

“实在布里斯托一直都是英国的IT重镇。它与周围的斯温顿、格洛斯特组成一个三角地带,被称为欧洲的‘硅谷’。半导体公司若是在欧洲设立研发中央,布里斯托通常是首选。譬如英伟达、惠普、博通、高通等世界级巨头都在布里斯托设有办事处。”

一位领会欧洲半导体产业的从业者告诉虎嗅,许多人由于ARM对剑桥印象深刻,但从历史来看,实际上布里斯托才是英国的芯片设计中央。

“华为也在布里斯托也有研发中央。”

就像上世纪50年代,8位天才“叛徒”脱离仙童半导体建立英特尔、AMD、泰瑞达等公司,才成就了现在的硅谷一样,布里斯托才华横溢的工程师们也不甘于停留在“已往”——在摩尔定律失效争议进入热潮,人工智能、盘算结构发生异变的“临界点”上,没有人不盼望能够成为谁人改变时代的领导者。

一位名叫 Simon Knowles 的工程师从剑桥大学毕业后,在1989年第一次踏上布里斯托的土地,接受了存储器企业Inmos的一份芯片设计事情。

在今后近20年里,从Inmos内部一个专用处置器团队的领导者,再到两家半导体企业Element 14与 Icera的首创人之一,Knowles险些见证了摩尔定律到达巅峰和走向衰落的全历程。而幸运的是,Knowles介入建立的这两家总估值跨越10亿美元的公司,划分在2000年和2011年被博通和英伟达收购。

没有任何意外,这位天才半导体设计师与延续创业者,又继续在2016年重新起劲别辟门户,与另一位天才半导体工程师Nigel Toon建立了一家新的半导体设计公司,自动迎击人工智能市场需求触发的芯片架构创新机遇。

没错,这家公司就是刚在2020年12月29日宣布完成2.22亿融资(这笔融资也让公司的资产负债表上拥有4.4亿美元现金),估值已高达27.7亿美元,被外媒称为英伟达最大对手之一的人工智能加速处置器设计商Graphcore。

需要注重,它也是现在西方AI芯片领域唯一的独角兽。

图片为Graphcore的IPU处置器

西方私募与风投看待半导体这种项目一直异常郑重,由于它们资金高度麋集且无法预估前期投资回报。正如Knowles在一次采访时认可:“与能够小规模实验、不乐成再换一个坑的软件产业相比,若是一枚芯片设计失败,除了花光所有钱,公司险些无路可选。”

因此,直到2018年以后,随着人工智能商业化的可能性被连续宣扬和放大,投资者们才确定可以从“人工智能大规模运算驱动芯片结构转变”的趋势中看到回报远景。

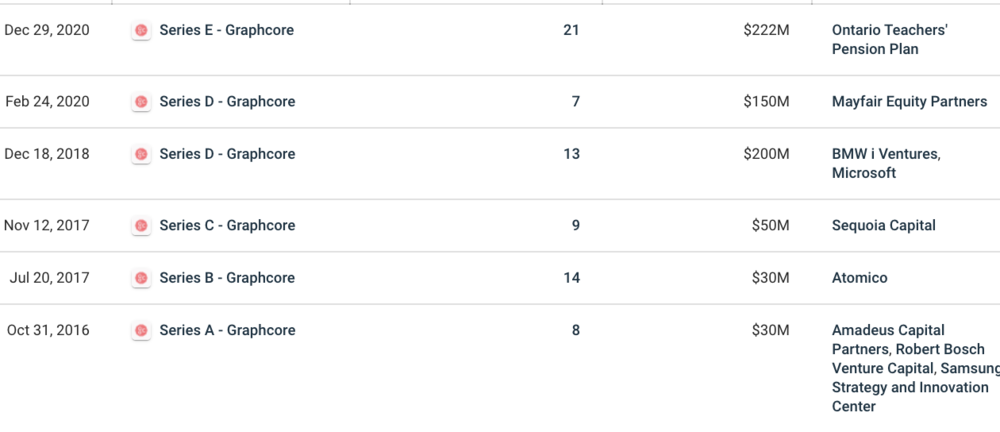

于是,在2017年获得了跨越8000万美元投资后的Graphcore,又接连在2018年与2020年划分获得2亿与1.5亿美元风险投资。

需要注重的是,除了博世、三星从A轮就最先参投,红杉资本是Graphcore的C轮领投方,而微软与宝马i风投则成为其D轮融资领投方;

而E轮融资的主要介入者,则是非产业基金——加拿大安大略省西席养老金计划委员会领投,富达国际与施罗德团体也加入了这轮融资。

你可以从投资方看出,Graphcore的产业投资方基本分为三个产业偏向——云盘算(数据中央)、移动装备(手机)与汽车(自动驾驶)。没错,这是三个最早被人工智能手艺“入侵”的产业。

图片来自Crunchbase

图片来自Crunchbase

工业界们似乎越来越杀青这样一个共识,未来需要有一家像ARM主导移动装备时代一样的底层创新企业,除了有希望卖出上亿块芯片的同时,也能推动人工智能与各个产业的深度整合,最终触到达上百亿通俗消费者。

从产物的角度来看,Graphcore 在2020年拿出了相对引人注目的作品——推出第二代 IPU-M2000芯片,该芯片搭载在一个名为IPU Machine platform的盘算平台上。另外,其芯片配套的软件栈工具Poplar也有同步更新。

“教盘算机若何学习,与教盘算机做数学题,是完全差别的两件事。提升一台机械的‘明白力’,底层驱动注重的是效率,而不是速率。” Graphcore CEO Nigel Toon 将新一代AI芯片的开发事情视为一个“千载一时的机遇”。

“任何公司能做到这一点,都能分享对未来几十年人工智能手艺创新和商业化的决议权。”

切中英伟达的“软肋”

没有一家AI芯片设计公司不想干掉市值高达3394亿美元的英伟达。或者说,没有一家公司不想做出比GPU更好的人工智能加速器产物。

因此,近5年来,大大小小的芯片设计公司都倾向于在PPT上,用英伟达的T4、V100,甚至是近期公布的“最强产物”A100与自己的企业级芯片产物做对照,证实自己的处置器拥有更好的运算效率。

Graphcore也没有破例。

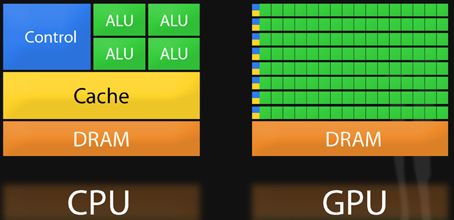

他们同样以为,由于上一代的微处置器——譬如中央处置器(CPU)和图形处置单元(GPU)并不是为人工智能相关事情而专门设计,工业界需要一种全新的芯片架构,来迎合全新的数据处置方式。

固然,这样的说法并不是利益相关者们的单纯臆想。

我们无法忽视来自学术界与产业界对GPU越来越多的杂音——随着人工智能算法训练与推理模子多样性的迅速增添,在降生之初并不是为了人工智能而设计的GPU露出出了自己“不善于”的领域。

“若是你做的只是深度学习里的卷积神经网络(CNN),那么GPU是一个很好的解决方案,但网络已经越‘长’越庞大,GPU已经难以知足AI开发者们越来越大的胃口。”

一位算法工程师向虎嗅指出,GPU之以是快,是由于它天生就能并行处置义务(GPU的释义和特点可以看《干掉英伟达》这篇文章)。若是数据存在“顺序”,无法并行,那么还得用回CPU。

“许多时刻既然硬件是牢固的,我们会想设施从软件层,把存在顺序的数据,变为并行的数据。譬如语言模子中,文字是延续的,靠一种‘导师驱动’的训练模式就可以转换为并行训练。

但一定不是所有模子都可以这么做,譬如深度学习中的‘强化学习’不太适适用GPU,而且也很难找到并行方式。”

由此来看,学术圈不少人甚至喊出“GPU阻碍了人工智能的创新”这句话,并不是耸人听闻。

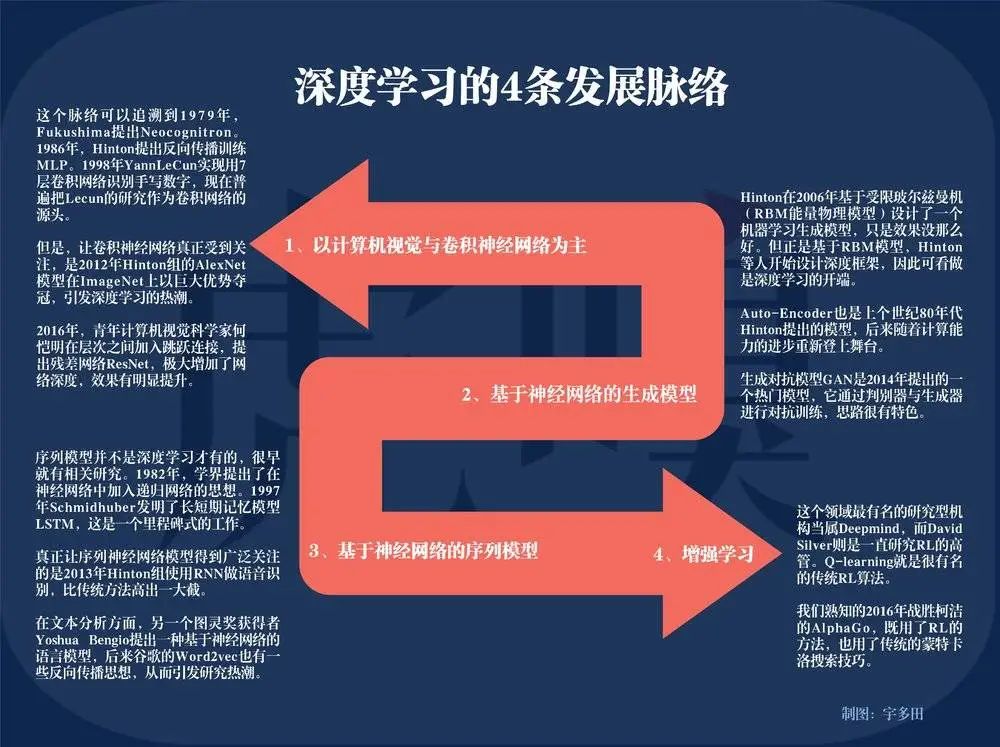

深度学习的4个生长脉络,制图:宇多田

“深度学习”,这个近10年来机械学习领域生长最快的一个分支,其神经网络模子生长之快、类型之广,只靠GPU这块硬件的“一己之力”是很难追上其庞大运算脚步的。

Graphcore 回复了虎嗅一份更为详尽的谜底。他们以为,对于深度学习中除去CNNs的另外几个分支,特别是循环神经网络(RNN)与强化学习(RL),让许多开发者的研究领域受到了限制。

譬如,用强化学习做出了阿尔法狗的英国AI公司 Deepmind,很早就由于GPU的盘算局限问题而关注Graphcore,其首创人Demis Hassabis最后成为了Graphcore的投资人。

“许多企业产物部门的开发者把需求(特别是延时和吞吐量的数据指标)交给算力平台部门时,他们通常会拒绝说 ‘GPU 现在不够支持这么低的延时和这么高的吞吐量’。

主要原因就在于,GPU的架构更适用于‘静态图像分类与识别’等拥有高浓密数据量的盘算机视觉(CV)义务,但对数据希罕的模子训练并不是最好的选择。

而跟文字相关的“自然语言处置”(NLP)等领域的算法,一方面数据没那么多(希罕),另一方面,这类算法在训练历程中需要多次通报数据,并迅速给出阶段性反馈,以便为下一步训练提供一个便于明白上下文的语境。”

换句话说,这是一个数据在连续流动和循环的训练历程。

就像淘宝界面的“猜你喜欢”,在第一天在“学习”了你的浏览和订单数据后,把不太多的履历反馈给算法举行修正,第二天、第三天以及未来的每一天不停学习不停反馈,才会变得愈加领会你的产物喜欢。

而这类义务,譬如谷歌为更好优化用户搜索在2018年提出的BERT模子,即是优异且影响深远的RNN模子之一,也是Graphcore提到的“GPU异常不善于的一类义务”。为领会决这类问题,仍然有许多公司在使用大量CPU举行训练。

CPU与GPU架构对比

从根本上看,这实在是由当下芯片运行系统最大的瓶颈之一决议的——若何在一块处置器上,将数据尽可能快地从内存模块传送到逻辑操作单元,且不费那么多功耗。在进入数据爆炸时代后,解锁这个瓶颈便愈加迫在眉睫。

举个例子,2018年10月 BERT-Large 的模子体量照样3.3 亿个参数,到2019年,GPT2的模子体量已到达15.5亿(两个均属于自然语言处置模子)。可以说,数据量对从系统底层硬件到上层SaaS服务的影响已经不能小觑。

而一块传统的GPU或CPU,固然可以执行延续多个操作,但它需要“先接见寄存器或共享内存,再读取和存储中心盘算结果”。这就像先去室外地窖拿储存的食材,然后再回到室内厨房举行处置,来来回回,无疑会影响系统的整体效率和功耗。

因此,许多半导体新兴企业的产物架构焦点思绪,即是让“内存更靠近处置义务,以加速系统的速率”——近存算一体。这个观点实在并不新鲜,但能做出真器械的公司少之又少。

而Graphcore到底做到了什么?简朴来说,即是“改变了内存在处置器上的部署方式”。

在一块差不多像小号苏打饼一样大的IPU处置器上,除了集成有1216块被称为IPU-Core的处置单元,其与GPU和CPU最大的差别,即是大规模部署了“片上存储器”。

简言之,即是将SRAM(静态随机存储器)涣散集成在运算单元旁,甩掉了外接存储,最大水平削减数据的搬移量。而这种方法的目的,就是想通过削减负载和存储数目来突破内存带宽瓶颈,大大削减数据传输延迟,同时降低功耗。

IPU架构

也正由于如此,在一些特定算法的训练义务中,由于所有模子都可以保存在处置器中,经由测试,IPU的速率简直可以到达GPU的20~30倍。

举个例子,在盘算机视觉领域,除了赫赫有名且应用普遍的残差网络模子ResNets(与GPU很契合),基于分组卷积与深度卷积偏向的图像分类模子 EfficientNet 和 ResNeXt 模子也是逐渐兴起的研究领域。

而“分组卷积”有个特点,就是数据不够浓密。

因此,微软机械学习科学家 Sujeeth 用Graphcore的IPU做了一次基于EfficientNet模子的图像分类训练。最后的结果是,IPU用30分钟的时间完成了一次新冠肺炎胸部X光样片的图像剖析,而这个事情量,通常需要传统 GPU 用5个小时来完成。

重重磨练

然则,就像GPU的大热与盘算机视觉领域的主流算法模子ResNets的普遍应用的相辅相成,决议Graphcore乐成照样失败的要害,也在于“特定”。

就像Graphcore销售副总裁兼中国区总经理在接受虎嗅采访时指出:

一方面,他们的产物简直更适用于训练市场中数据较为希罕,精度要求较高的深度学习义务,譬如与自然语言处置相关的推荐义务,这也是阿里云与百度愿意与之杀青互助的主要原因之一。

另一方面,盘算机视觉领域刚流行起来的新模子,是IPU在起劲“攻克”的偏向,而之前许多模子,照样GPU最应手。

此外,GPU缔造的壮大软件生态Cuda,比硬件更不容易被损坏(关于Cuda,也在《干掉英伟达》这篇文章里有详细注释),而这层围墙恰恰是开拓产业影响力的要害。

毫无疑问,Graphocore在这方面基本尚浅,因此除了通例操作,他们选择基于编程软件Poplar,做一些相对勇敢的实验。

譬如,他们在自己的开发者社区开放盘算图库PopLibs的源代码,让开发者去实验形貌一种新的卷积网络层。这一层对标的是GPU的cnDNN和cuBLAS,而英伟达并没有开放它们。

为了向开源社区致敬,Poplar v1.4增添了对 PyTorch 的周全支持。这一伶俐的行为将有助于简化人们的接受水平,有助于吸引更普遍的社区介入。

此外,为了能够尽快打开市场,Graphcore并没有走“打竞赛来提升产业知名度”的实验室销售门路,而是将IPU直接推入了产业界,去逐个敲开服务器集成商、云厂商等客户的大门。

“AI这个行业自己,不管是算法的迭代照样模子的转变,实在都是异常快的。有云厂商曾埋怨,说某家处置器跑某一种模子性能异常好,但模子稍微改一改,跑出来的性能就大跌眼镜。”

Graphcore中国区手艺应用总负责人罗旭以为,只管市场在大量宣扬ASIC(专用芯片)和FPGA(可编程芯片),但通用性,仍然是产业界思量芯片的首要条件,尤其是互联网厂商。

“互联网厂商应用异常多,每个应用都市有差别的适用模子。若是一个处置器只能适配一个模子,那客户是无法引入这个处置器做大量推广的。”

而“编程环境是否友好”,也就是英伟达Cuda孝敬的那种气力,是第二个要害的采购指标。

“现在客户一样平常都是用AI框架来设计模子,好比谷歌的TensorFlow、Facebook的PyTorch等等。他们会思量这枚处置器的上层SDK是否能够轻松接入到框架里,以及编程模子是否好用。

客户可能会有一些算子级别的优化,需要做一些自定义算子。自定义算子开发起来是否利便实在也是取决于编程友好性若何。”

若是说客户还在乎什么,固然是产物性能。

无论是云厂商、服务器厂商照样通过云服务购置算力的开发者,都市测试多种模子跑在芯片上的性能显示。

“若是他们主要看重NLP(自然语言处置)模子,那在性能测试时就可能重点测一下BERT。若是他们看重盘算机视觉,那在性能测试时就可能重点测试一些盘算机视觉的经典模子。

总的来说,客户需要从以上几个维度综合评估下来,才气决议到底要不要使用这个处置器,或者说,必须确定这个处置器能给他们带来多大的收益。”

而在这个方面,无论是英伟达,照样Graphcore的IPU或其他厂商的专用芯片,都是有自己最善于的模子,只能说是“各有千秋”,绝对不能以偏概全。

赢家通吃,将不复存在

从Graphcore给出的产物基准测试指标与宣传重点来看,这家公司正在拿着锤子找钉子,起劲扩展IPU善于的应用场景,以便让IPU架构能够施展最大效率。

换句话说,Graphcore或许会分英伟达的一杯羹,但永远不能能取代它们。

正如“特定”这个词的寄义所限,人工智能训练与推理芯片市场,因模子的多样性与庞大性,一定能够容纳包罗英伟达、Graphcore在内更多的芯片企业。

Nigel Toon也认可,人工智能盘算将孕育出三个芯片垂直市场:

相对简朴的小型专用加速器市场,譬如手机、摄像头以及其他智能装备里的某个IP核;

再譬如适用于数据中央某几个功效的ASIC芯片,详细问题详细解决,超大规模数据中央运营商(云厂商)将在这个市场中有大量机遇;

最后一个是可编程的AI处置器,也就是GPU所在的市场。这个市场一定会有更多企业,同时未来更多的创新也一定会发生更大的份额。

CPU会连续存在,GPU也会连续创新,他们在某些AI盘算义务上都是不能或缺的,或者说是最好的选择。然则摩尔定律失效、AI盘算和数据爆炸等趋势催生出的新市场,一定是伟大且多样性的。正是由于多样性,以是才给了更多专用芯片公司新的机遇。

因此,像Cerebras、Groq、 SambaNova Systems 、Mythic AI 这样的芯片创业公司才得以筹集到数亿美元资金,英特尔也在今年投资了刷新AI芯片架构的Untether AI。已经有不少人给出这样的展望——新一代的‘苹果’与‘英特尔’可能会在人工智能盘算市场中降生。

在软件还没有跟上硬件措施的当下,这意味着猛烈的竞争才刚刚最先。